الجوانب الأخلاقية لـ الذكاء الاصطناعي: هل الذكاء الاصطناعي خطر؟

الذكاء الاصطناعي بين الفائدة والتهديد: أين تكمن الأخلاقيات؟

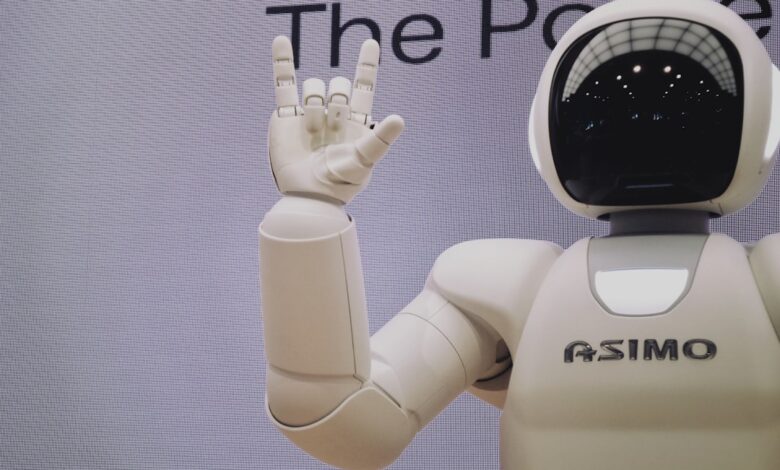

في عصر يتسارع فيه تطور التكنولوجيا، يبرز الذكاء الاصطناعي كواحد من أكثر الابتكارات إثارة للجدل. بينما يقدم حلولًا ثورية في مجالات مثل الطب والصناعة، تطفو على السطح تساؤلات أخلاقية عميقة: هل يشكل الذكاء الاصطناعي خطرًا على البشرية؟ وما هي الحدود الفاصلة بين الاستفادة منه والانزلاق نحو مخاطر غير محسوبة؟

الذكاء الاصطناعي: بين الثورة والقلق

لطالما كان الذكاء الاصطناعي أداة لتعزيز الكفاءة في مختلف القطاعات، من التشخيص الطبي الدقيق إلى تحسين سلاسل التوريد. لكن مع تزايد الاعتماد عليه، بدأت المخاوف تظهر حول تأثيره على سوق العمل، خصوصًا مع استبدال الوظائف التقليدية بأنظمة آلية. الأكثر إثارة للقلق هو قدرة الذكاء الاصطناعي على اتخاذ قرارات قد تؤثر مباشرة على حياة البشر، مثل السيارات ذاتية القيادة أو أنظمة الأسلحة المستقلة.

الأخلاقيات المفقودة: من يتحمل المسؤولية؟

عندما يرتكب الذكاء الاصطناعي خطأً، من المسؤول؟ هل هو المطورون، أم الشركات المصنعة، أم الخوارزميات نفسها؟ هذه الأسئلة تفتح بابًا واسعًا للنقاش حول المساءلة القانونية والأخلاقية. على سبيل المثال، إذا تسبب نظام ذكاء اصطناعي في حادث مروري، هل يمكن مقاضاة البرنامج؟ غياب الإطار الأخلاقي الواضح يجعل من الصعب تحديد الجهة المسؤولة، مما يعرض حقوق الأفراد للخطر.

التحيز الخوارزمي: هل الذكاء الاصطناعي عادل؟

من أكبر التحديات الأخلاقية التي تواجه الذكاء الاصطناعي هي مشكلة التحيز في البيانات. كثيرًا ما تكرر الأنظمة الخوارزمية التحيزات الموجودة في البيانات التي تم تدريبها عليها، مما يؤدي إلى تمييز ضد فئات معينة بناءً على العرق أو الجنس. هذه المشكلة تظهر جليًا في مجالات مثل التوظيف أو منح القروض، حيث قد يحرم الأفراد من فرص حيوية بسبب تحيز غير مقصود.

الخصوصية والمراقبة: حدود لا يجب تجاوزها

مع قدرة الذكاء الاصطناعي على تحليل كميات هائلة من البيانات، أصبحت قضية الخصوصية أكثر إلحاحًا. أنظمة التعرف على الوجه والتتبع السلوكي تثير تساؤلات حول مدى شرعية جمع البيانات الشخصية. في غياب تشريعات صارمة، قد تتحول هذه التقنيات إلى أدوات للقمع أو انتهاك الحريات الفردية تحت ذرائع مثل “الأمن الوطني”.

مستقبل الذكاء الاصطناعي: كيف نضمن الاستخدام الأخلاقي؟

لضمان أن يظل الذكاء الاصطناعي أداة للإثراء البشري وليس التدمير، يجب وضع معايير أخلاقية صارمة تشمل:

– الشفافية: فهم كيفية اتخاذ القرارات داخل الخوارزميات.

– المساءلة: تحديد الجهات المسؤولة عن الأضرار المحتملة.

– الإنصاف: ضمان عدم تعزيز التحيزات الاجتماعية.

– الخصوصية: حماية البيانات الشخصية من الاستغلال.

التوازن بين الابتكار والأخلاق ليس خيارًا، بل ضرورة. الذكاء الاصطناعي ليس خطرًا بحد ذاته، لكن سوء استخدامه أو إهمال ضوابطه قد يحوله إلى تهديد حقيقي. المستقبل يعتمد على كيفية تعاملنا مع هذه التكنولوجيا اليوم.